뇌질환의 생명정보학 데이터를 기계학습과 생성 AI 모델을 사용해 연구하면서 인공지능이 데이터를 학습하는 방식과 우리 인간이 무언가를 배우는 방식의 차이점과 유사점에 대해 생각하게 된다. 인공지능의 기초가 되는 퍼셉트론 기반 딥러닝, 이미지 분석을 위한 합성곱 신경망 등은 뇌과학에서 영감을 받았지만, 현대 인공지능 알고리즘은 이제 뇌과학과 크게 관련 없이 발전했다. 그럼에도 불구하고 인간의 학습 방식에 적용될 수 있다고 생각되는 통찰들이 있다.

2023년 초 등장한 대규모 언어 모델인 챗(Chat)GPT4와 같은 트랜스포머 기반 생성 모델들은 필자가 연구하고 있는 오믹스와 인공지능 융합 분야에서도 이미 2021년부터 연구 중이다. 모든 혁신의 기반이 된 것은 구글 연구팀이 2017년에 발표한 'Attention is all you need'라는 논문이다. 이 논문에서는 단어들 사이의 연관성을 학습하는 새로운 방법을 소개했는데, 단순히 문법적인 규칙을 배우는 것이 아니라 단어들 사이의 관계를 확률적으로 이해하는 방식이다. 이러한 접근 방식이 생성형 언어 모델에서 너무나도 효과적이라 필자는 인간의 학습 방식에도 적용할 수 있는지 궁금했다.

한국인이 영어를 배울 때 한글과 영어 단어를 일대일로 대응시켜 배우는 방식보다 영어 문장 내에서 단어들 사이의 관계를 확률로 이해하고, 한글과 영어 문장 사이에서 단어들의 다대다 대응을 확률적으로 배우는 것이 가능할지 생각해 봤다. 이런 방식의 학습은 영어 스피킹 교육 전문가들이 이미 사용하고 있다. 이런 배경에서 'self & cross attention' 기반의 트랜스포머 알고리즘이 인간의 학습 방식에도 유용한 통찰을 줄 수 있을 것이다.

또 다른 통찰은 데이터에 대한 처리 방식에서 왔다. 뇌질환 환자들의 혈액이나 뇌 조직에서 얻은 유전자 발현 데이터를 연구하다 보면, 데이터의 불균일성이나 진단의 정확성에 대해 의문이 생기기도 한다. 이런 데이터에는 종종 오류가 있거나 예외적인 경우가 포함돼 있어 이를 처리하는 것이 매우 중요하다. 좋은 데이터를 충분히 확보하고, 오류를 제거하는 데이터 전처리 과정은 알고리즘 개발보다 더 중요할 수 있다. 하지만 너무 깔끔하게 분류된 데이터만 사용하면 범용성이 떨어지고, 너무 세부적인 문제에만 집중하는 경향이 생길 수 있다. 그래서 연구의 목표와 환경을 고려해 데이터의 범위를 적절히 설정하는 것이 중요하다.

우리는 태어나서 죽을 때까지 새로운 것을 배운다. 이 과정에서 우리 뇌의 시냅스 가소성, 즉 신경세포끼리 유연하게 연결을 바꾸는 능력이 활발하게 작용해 기존의 기억과 학습 능력이 변한다. 만약 우리가 너무 특정한 유형의 문제만을 학습한다면 새로운 상황에 대처하는 능력이 약해질 수 있다. 그렇다고 너무 일그러진 데이터만을 학습하면 보편적인 학습 능력이 저하될 위험이 있다.

현대 사회에서 우리는 정보의 홍수 속에서 살고 있다. 정보의 과잉은 우리가 더 똑똑하다고 착각하게 할 수 있지만, 실제로는 중요한 일에 집중하는 능력을 떨어뜨리고 사회적 업무 능력도 떨어뜨린다.

이러한 이유로 어떤 정보를 받아들이고 어떻게 학습할지 우리는 신중하게 선택해야 한다. 특히 잘못된 표시(레이블)가 붙은 정보나 분석하기 어려운 정보를 걸러내는 전처리 과정은 매우 중요하다. 이는 우리 스스로가 원하는 모습을 만들고, 주어진 과제를 성공적으로 수행하는 데 결정적인 역할을 할 것이다. 인공지능이 그러하듯이 말이다.

경제부 jebo@imaeil.com

댓글 많은 뉴스

'尹파면' 선고 후 퇴임한 문형배 "헌재 결정 존중해야"

'퇴임 D-1' 문형배 "관용과 자제 없이 민주주의 발전 못해" 특강

"조직 날리겠다" 文정부, 102차례 집값 통계 왜곡 드러나

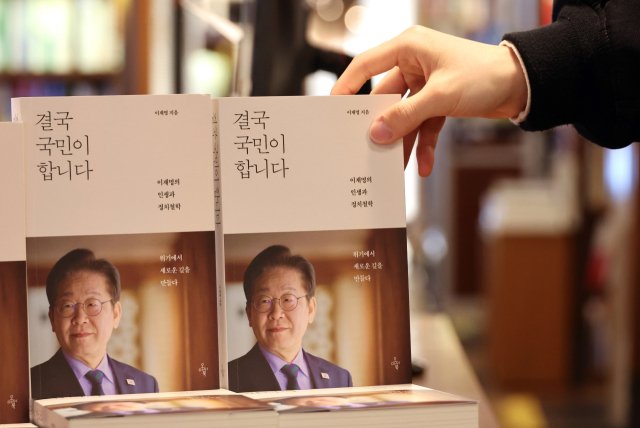

이재명 "대구·경북의 아들 이재명, TK 재도약 이끌겠다"

안 "탈당해야" 김·홍 "도리아냐"…국힘 잠룡들 尹心 경계 짙어질까